Primeras experiencias para construir la Red Colombiana de Computación Avanzada: LaRedCCA

First experiences to build the Advanced Computing Colombian Network: LaRedCCA

ACI Avances en Ciencias e Ingenierías

Universidad San Francisco de Quito, Ecuador

Recepción: 25 Junio 2021

Aprobación: 16 Septiembre 2021

Resumen: La Red Colombiana de Computación Avanzada (LaRedCCA) fue establecida para fortalecer la comunidad de supercómputo y unir conocimientos, recursos e infraestructura distribuida geográficamente en Colombia mediante la red académica. Igualmente busca integrar los centros de recursos de computación de alto rendimiento para soportar iniciativas científicas y académicas de interés nacional y sin ánimo de lucro. Ha sido conformada inicialmente por el SC3UIS (Supercomputación y Cálculo Científico) de la Universidad Industrial de Santander, la Universidad de los Andes y la Red Nacional Académica de Tecnología Avanzada (RENATA). LaRedCCA ha establecido un banco de prueba inicial para compartir recursos informáticos a través de un enlace de alta velocidad proporcionado por RENATA y busca apoyar la investigación en todas las áreas del ecosistema científico y tecnológico del país, impulsando áreas como la computación paralela y distribuida, la inteligencia artificial y el Big Data. Este enlace ha mostrado resultados interesantes al proporcionar un canal HPC dedicado que proporciona un alto ancho de banda para la transferencia de datos para análisis posteriores o simulaciones realizadas por los centros de investigación de la Universidad de los Andes en y en los recursos de computación de alto rendimiento de SC3UIS, principalmente en la plataforma GUANE-1.

Palabras clave: Centros de supercomputación y alto rendimiento, Redes Académicas, Redes de computadores.

Abstract: The Colombian Network for Advanced Computing (LaRedCCA) was established to strengthen the supercomputing community and unite knowledge, resources, and infrastructure geographically distributed in Colombia through the academic network. It also seeks to integrate high-performance computing resource centers to support scientific and academic initiatives of national interest and not for profit. It has been initially formed by the SC3UIS (Supercomputing and Scientific Calculation) of the Industrial University of Santander, the University of the Andes, and the National Academic Network for Advanced Technology (RENATA). The RedCCA has established an initial test bed to share computing resources through a high-speed link provided by RENATA and seeks to support research in all areas of the country's scientific and technological ecosystem, promoting areas such as parallel and distributed computing, artificial intelligence, and Big Data. This link has shown interesting results by providing a dedicated HPC channel that provides high bandwidth for data transfer for subsequent analysis or simulations performed by the research centers of the Universidad de Los Andes in and on high computing resources. SC3UIS performance, mainly on the GUANE-1 platform.

Keywords: High-Performance Computing Centers, Academic Networks, Networking.

INTRODUCCIÓN

La computación de alto rendimiento ha soportado por años la investigación en diferentes campos de la ciencia y la ingeniería, durante los cuales se han hecho grandes saltos en innovación tanto en el mismo campo de las ciencias computacionales como en los que se han apoyado en él. Esto ha motivado a múltiples entidades tanto públicas como privadas a adquirir sus propios entornos de trabajo, háblese de computadores personales con altas prestaciones, Workstation y/o servidores con especificaciones para computo avanzado, pero muchas de estas, han visto las dificultades existentes a medida que escalan sus problemas y se plantean nuevos retos en sus investigaciones. Estos problemas van desde el simple inconveniente de contar con personal capacitado en tareas de cómputo avanzado, administración de este tipo de entornos, costos de mantenimiento hasta ver que sus recursos disponibles no cuentan con la capacidad necesaria para la ejecución de sus trabajos. El ultimo problema planteado suele ser el mayor limitante y el acceso a recursos con mayores prestaciones puede incurrir en sobrecostos en los cuales la gran mayoría de los investigadores no puede incurrir.

LaRedCCA fue conformada para fortalecer a la comunidad de supercómputo en Colombia junto con la meta de apoyar, soportar y prestar recursos de cómputo avanzado a los diferentes entidades nacionales que desarrollan proyectos de investigación sin ánimo de lucro y que requieren de estas capacidades. La red busca crear un entorno colaborativo para generar un espacio de interacción entre estudiantes, científicos e investigadores, facilitando el acceso al conocimiento, experiencias y diferentes herramientas.

La primera sección describe la Red Colombiana de Computación Avanzada, quienes la conforman en esta primera experiencia y hace una breve descripción técnica. En la segunda sección se realiza una descripción técnica sobre supercómputo, se detallan los recursos que se han proporcionado y se especifica el sistema de manejo de usuarios. En la tercera se muestran los resultados de la obtenidos de esta primera experiencia mediante dos pruebas realizadas: medición de ancho de banda y, acceso, soporte y ejecución de trabajos en entornos de supercómputo por parte de los grupos de investigación invitados. La cuarta sección se discutes los resultados obtenidos y se realiza una descripción de las posibles causas de estos. Finalmente, se realizan las conclusiones generadas de esta primera experiencia.

ÜCI LAREDCCA

La Red Colombiana de Computación Avanzada (LaRedCCA) nace en junio de 2019 con el objetivo de generar un espacio que favorezca la colaboración de los investigadores mediante el uso de escenarios de supercómputo. Esta red busca acompañar, beneficiar y fortalecer el proceso educativo científico y tecnológico en Colombia, así como generar un espacio de interacción entre estudiantes, científicos e investigadores potenciando los proyectos y trabajos conjuntos, facilitando el acceso al conocimiento, experiencias y diferentes herramientas que se brindan a través de LaRedCCA.

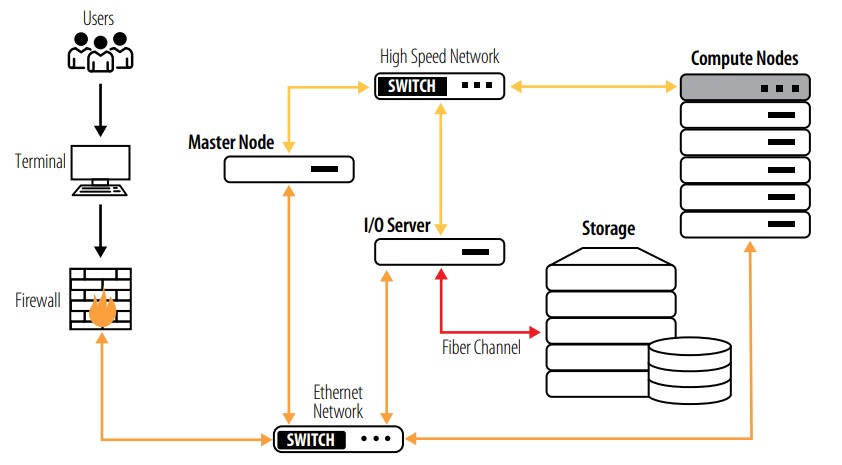

RENATA (Red Nacional Academica de Tecnologia Avanzada, 2021) junto con el SC3 (Supercomputacion y Calculo Cientifico, 2021) de la UIS (Universidad Industrial de Santander, 2021) y UniAndes (Universidad de los Andes, 2021) se han enlazado para desarrollar esta primera experiencia de interconexión de plataformas y servicios HPC (o de Cómputo de alto rendimiento, de las siglas en inglés High Performance Computing) permitiéndole a diferentes investigadores acceder a este tipo de recursos y proporcionándoles entornos de trabajo que mejoren sus tiempos de investigación y abarcar problemas más amplios en sus respectivos campos. En la Figura 1 se observa el esquema general de la interconexión realizada en el cual ambos clústeres pueden verse a través de direcciones IP públicas proporcionadas por RENATA y que además proporciona un canal dedicado, seguro y eficiente para la transferencia de grandes volúmenes de datos entre las plataformas. Es importante tener en cuenta que el ancho de banda con el que cuenta UniAndes es de 100 Mbits/s mientras que el de la UIS es de 1 Gbit/s y por lo cual, la conexión estará limitada al mínimo valor. Por otro lado, SC3 cuenta con una firewall para monitorear y proteger el tráfico y conexiones entrantes y salientes que se realicen al servidor de entrada a la plataforma HPC.

FIGURA 1

Esquema de conexión entre SC3UIS/RENATA/UniAndes.

En la siguiente sección se hablará sobre que es HPC, los recursos que se han proporcionado para el trabajo de los investigadores y como se ha manejado el acceso de estos a LaRedCCA.

HIGH-PERFORMANCE COMPUTING - SC3UIS/UNIANDES

La computación de alto rendimiento es el campo de las ciencias de la computación que busca aumentar el rendimiento para la resolución de problemas de ciencia, ingeniería y negocios. Estos problemas, que son computacionalmente complejos, son modelados matemáticamente y que mediante técnicas de computación paralela se convierten en instrucciones de código que pueden ejecutarse en máquinas de cómputo paralelo más conocidas como supercomputadores (Clustering fundamentals, 2021).

Los supercomputadores modernos fueron introducidos en la década de 1960 por Seymour Cray (Thornton, 1980) y desde entonces han evolucionado de tal forma que han alcanzado el orden de los PetaFLOPS (1015 Operaciones de punto flotante por segundo) gracias a la creciente demanda de altas velocidades de cómputo para resolver problemas en áreas como la mecánica cuántica, la predicción del clima, exploración de petróleo y gas, entre otras. El hardware HPC se divide en tres categorías principales: multiprocesador simétrico (SMP), procesadores vectoriales y clústeres Beowulf (Clustering fundamentals, 2021), siendo este último el más popular.

En la última década, el desarrollo de estos supercomputadores se ha debido al boom de la inteligencia artificial, particularmente a los algoritmos de Deep Learning, los cuales han sido aplicados al desarrollo de diferentes campos como la visión por computador, predicción de textos y como apoyo para la resolución de problemas de otras áreas, como las nombradas anteriormente.

De manera general, un clúster HPC, está compuesto por cuatro elementos fundamentales: nodos de administración, nodos de cómputo, sistema de almacenamiento y la red de interconexión tal como se muestra en la Figura 2. Existen otros elementos físicos en este tipo de configuraciones como nodos de I/O, Firewalls y nodos de control de usuarios que no son esenciales, sin embargo, no contar con los nodos físicos no implica que no se requiera del servicio para un correcto funcionamiento (Torres & Barrios, 2021).

FIGURA 2

Esquema general acceso a los recursos HPC de SC3UIS

En ese orden de ideas, varios centros de investigación y universidades en todo el mundo adquirieron y configuraron sus propios supercomputadores para llevar a cabo los diferentes procesos de investigación que se llevan a cabo en estas entidades. Cabeanotar que estas máquinas además de su elevado costo de adquisición conllevan a costos secundarios de mantenimiento y administración y, por lo cual, es un recurso de difícil acceso para muchos investigadores.

Para esta primera experiencia en donde se busca proveer de recursos computacionales de altas prestaciones a los investigadores, se vinculan dos universidades: la Universidad Industrial de Santander con el Centro de Supercomputación y Cálculo Científico (SC3) y la Universidad de los Andes. Los dos clústeres proporcionados para el trabajo en la red presentan las siguientes características:

GUANE-1, FELIX y YAJE

-

8 nodos de cómputo:

-

2 Intel(R) Xeon(R) CPU E5645 @ 2.40GHz

-

104 GBRAM

-

8 GPU Tesla M2075

-

-

3 nodos de cómputo:

-

2 Intel(R) Xeon(R) CPU E5645 @ 2.40GHz

-

104 GB RAM

-

8 GPU Tesla S2050

-

-

5 nodos de cómputo:

-

2 Intel(R) Xeon(R) CPU E5640 @ 2.67GHz

-

104 GB RAM

-

8 GPU Tesla S2050

-

-

1 nodo de cómputo - FELIX:

-

4 Intel(R) Xeon(R) CPU X7560 @ 2.27GHz

-

125 GB RAM

-

2 GPU GeForce GTX TITAN X

-

-

1 nodo para visualización científica - YAJE:

-

1 Intel(R) Xeon(R) CPU E5-2609 v3 @ 1.90GHz

-

16 GB RAM

-

1 GPU GeForce GTX TITAN X

-

-

Storage HP Storage P2000 G3

-

10.8 TB de almacenamiento libre en RAID5

-

-

Red de Interconexión Infiniband

-

Velocidad de 40 Gb/s

-

UniAndes

-

2 nodos de cómputo:

-

2 x Intel(R) Xeon(R) CPU E5-2640 v3 @ 2.60GHz

-

GPU: NVIDIA SMI 410.48

-

256 GB RAM

-

1TB de almacenamiento

-

-

21 nodos de cómputo:

-

2 x Intel(R) Xeon(R) CPU E5-2695 v2 @ 2.40GHz

-

192GBRAM

-

1TB de almacenamiento

-

-

5 nodos de cómputo:

-

2 x Intel(R) Xeon(R) CPU E5-2690 v4 @ 2.60GHz

-

512GBRAM

-

1TB de almacenamiento

-

-

1 nodos de cómputo:

-

2 x Intel(R) Xeon(R) CPU E5-2699 v4 @ 2.20GHz

-

512GBRAM

-

1TB de almacenamiento

-

Red de Interconexión Infiniband

-

Almacenamiento 230 TB DDN

-

Finalmente, el acceso de los usuarios se manejó desde el servidor LDAP (Lightweight Directory Access Protocol, 2021) con el que se cuenta en la plataforma SC3UIS. Este servicio está configurado para manejar cuentas de usuario por instituciones, grupos de investigación y proyectos, lo cual permitió asignarles roles y permisos específicos para el uso del clúster.

En la sección presentada a continuación se mostrarán los resultados de dos evaluaciones realizadas específicamente para esta primera experiencia. La primera fue observar el comportamiento de la interconexión y la calidad que se ofrece a los investigadores para la transferencia de sus datos entre las instituciones. La segunda evaluación correspondió a darle accesos a dos grupos de investigación de la Universidad de los Andes y el soporte necesario para la correcta ejecución de los trabajos sobre el entorno HPC.

RESULTADOS

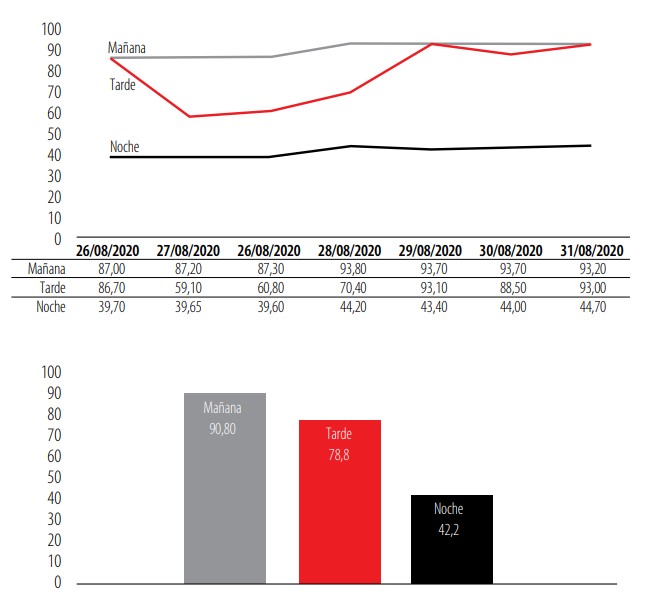

La primer evaluación se realizó usando iPerf/iPerf3 (iPerf - The ultimate speed test tool for TCP, UDP and SCTP, 2021) para medir el ancho de banda real entre las dos instituciones y determinar posibles problemas de conexión y configuración entre ambos puntos. El registro de los resultados obtenidos se puede apreciar en la Figura 3. Allí se encuentra registrada la información de cada prueba realizada. El día 27 de agosto hubo una falla del equipo de origen lo que impidió tener resultados de este horario, por lo cual se promedia el día anterior con el siguiente para obtener un valor para este día teniendo presente que el comportamiento general durante el periodo de estudio es muy similar.

Como se puede apreciar, durante los 7 días, en horarios de la mañana se mantiene un valor promedio cercano a 90 Mbit/s que viene siendo un valor relativamente cercano al teórico de 100 Mbit/s. En cuanto al resultado obtenido para horarios de la tarde, se encuentra un resultado con fluctuaciones para los diferentes días variando entre valores de 60 - 90 Mbit/s, proporcionando un valor medio de 78,8 Mbit/s. En los resultados obtenidos para horas de la noche, el ancho de banda desciende a valores que en promedio se sitúan en 42,2 Mbit/s.

FIGURA 3

Resultados de las pruebas de medición ancho de banda UniAndes-UIS (Mbits/s).

Para la evaluación de uso de LaRedCCA se invitaron a participar a dos grupos de la Universidad de los Andes: BIOMMAR (Biología Molecular Marina) y CMUA (Centro de Microelectrónica de la Universidad de los Andes). En cada grupo participó un investigador, el cual ejecutó diferentes pruebas tanto de conexión a través de las redes académicas, transferencia de datos y ejecución de tareas sobre el clúster HPC.

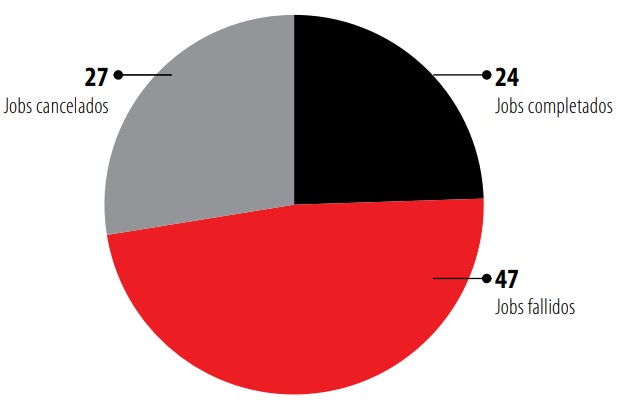

En cuanto a CMUA solicitaron el uso de los nodos con capacidades de entrenamiento de redes neuronales y espacio de disco de 300 GB junto con el software Darknet (Darknet: Open Source Neural Networks in C, 2021) y PyTorch (PyTorch, 2021). En la Figura 4 se observa el total de tareas lanzadas sobre la plataforma y su división entre las tareas ejecutadas, canceladas y fallidas dentro de la plataforma HPC. En cuanto al tiempo de uso de la plataforma por parte del grupo CMUA se obtuvo un total de 837 horas de cómputo.

FIGURA 4

Resumen de trabajos lanzados por CMUA.

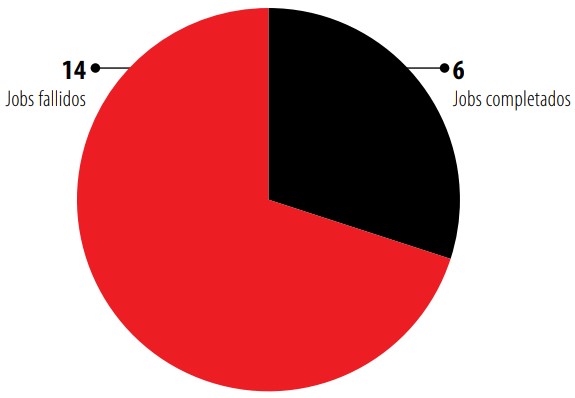

Por otra parte, en la Figura 5 se muestra que el grupo BIOMMAR presentó un menor uso de la plataforma durante el periodo en el cual se realizaron las primeras pruebas con solo 2 horas de cómputo.

FIGURA 5

Resumen de trabajos lanzados por BIOMMAR.

En la próxima sección se analizan los resultados obtenidos de las primeras pruebas realizadas y se establecen las principales motivos de ciertos comportamientos presentados durante el periodo de evaluación de LaRedCCA.

DISCUSIÓN

El ancho de banda total de la conexión entre SC3UIS y UniAndes es de 100 Mbits/s siendo este el máximo que puede alcanzar la conexión por parte de UniAndes. Las caídas en la trasferencia y durante las diferentes pruebas puede estar siendo provocado por el nivel de congestión tanto a nivel local como a nivel WAN, la conexión de cada organización con la NREN (National Research and Education Network) o el rendimiento de los equipos desde los cuales se realizaron las pruebas. En esta última parte es importante aclarar que las conexiones al clúster SC3UIS están filtradas por medio de una UTM/Firewall (Gestión unificada de amenazas, 2021) junto con un servidor de acceso a usuarios que valida su acceso antes de permitirles ingresar al frontend del clúster. Actualmente estos resultados siguen siendo investigados con la finalidad de alcanzar el uso total del ancho de banda.

En cuanto a los resultados obtenidos del uso de la plataforma, se observó que ambos grupos de investigación presentaron un gran número de trabajos cancelados o fallidos durante el lanzamiento de sus scripts. Esto se debe principalmente a la curva de aprendizaje normal cuando los usuarios saltan de usar las típicas Workstation a plataformas de supercomputación como la proporcionada por el SC3. En nuestra experiencia es un comportamiento normal de los usuarios y por ello se hace necesario realizar un acompañamiento constante a los investigadores durante las primeras semanas de trabajo.

Finalmente, se observó que el grupo BIOMMAR presento un significativo bajo uso de la plataforma durante el periodo de tiempo evaluado. Este comportamiento es debido esencialmente a el choque que se mencionó con anterioridad al realizar el salto a plataformas HPC y contrasta con el del grupo CMUA que ya contaba con cierta experiencia en este tipo de entornos.

CONCLUSIÓN

En conclusión, durante el periodo estudiado en estas primeras experiencias de LaRedCCA el uso de este tipo de plataformas HPC interconectadas mediante redes académicas permitió un significativo mejoramiento en el acceso de recursos a los investigadores junto con la creación de un entorno de trabajo colaborativo entre la Universidad Industrial de Santander y la Universidad de los Andes, Igualmente, se permitió crear un ecosistema de recursos computacionales aun mayor del que cada investigador puede acceder dentro de su campus académico.

En cuanto a los datos obtenidos en la medición de la estabilidad y ancho de banda de la red de interconexión, se puede observar fluctuaciones que van desde los 87 Mbps a los 93 Mbps sobre el canal de 100 Mbps de UniAndes. Por otra parte, se observó una disminución considerable del ancho de banda en horas de la tarde y de la noche; este comportamiento es actualmente objeto de estudio en LaRedCCA. Finalmente, la estabilidad y el ancho de banda proporcionados por RENATA muestran una conexión estable y confiable para los investigadores durante los procesos de transferencia de datos y de interconexión entre las plataformas.

AGRADECIMIENTOS

Este trabajo fue soportado RENATA junto con el Centro de Supercomputación y Cálculo Científico junto a la Universidad de los Andes. Agradecemos a los profesores Carlos Jaime Barrios Hernández y Harold Enrique Castro Barrera, quienes lideran la iniciativa científicamente.

CONTRIBUCIÓN DE LOS AUTORES

L. A. Torres: Conceptualization, Resources, Writing - Original Draft, Visualization. Arnold A. Lara: Conceptualization, Methodology, Validation. Carlos A. Ramírez Guzmán: Project administration, Writing - Review & Editing

CONFLICTO DE INTERÉS

Los autores cuyos nombres se enumeran inmediatamente a continuación certifican que NO tienen afiliaciones ni participación en ninguna organización o entidad con ningún interés financiero (como honorarios, becas educativas, participación en oficinas de oradores, membresía, empleo, consultorías, propiedad de acciones , u otra participación accionaria; y testimonio de expertos o acuerdos de licencia de patentes), o interés no financiero (como relaciones personales o profesionales, afiliaciones, conocimientos o creencias) en el tema o materiales discutidos en este manuscrito.

REFERENCIAS

[1] Clustering fundamentals. (2021, mayo). Retrieved from Clustering fundamentals: https://developer.ibm.com/articles/l-cluster1/

[2] Darknet: Open Source Neural Networks in C. (2021, mayo). Retrieved from Darknet: https://pjreddie.com/darknet/

[3] Gestión unificada de amenazas. (2021, mayo). Retrieved from UTM: https://latam.kaspersky.com/resource-center/definitions/utm

[4] iPerf - The ultimate speed test tool for TCP, UDP and SCTP. (2021, mayo). Retrieved from iPerf: https://iperf.fr/

[5] Lightweight Directory Access Protocol. (2021, mayo). Retrieved from LDAP: http://web.mit.edu/rhel-doc/5/RHEL-5-

[6] PyTorch. (2021, mayo). Retrieved from https://pytorch.org/

[7] Red Nacional Academica de Tecnologia Avanzada. (2021, mayo). Retrieved from RENATA: https://www.renata.edu.co/

[8] Supercomputacion y Calculo Cientifico. (2021, mayo). Retrieved from SC3: https://www.sc3.uis.edu.co/

[9] Thornton, J. E. (1980). The CDC 6600 Project. IEEE Annals of the History of Computing, 2, 338-348.

[10] Torres, L. A., & Barrios, C. J. (2021). Methodology for Design and Implementation an Efficient HPC Cluster. High Performance Computing (pp. 71-85). Springer International Publishing.

[11] Universidad de los Andes. (2021, mayo). Retrieved from UniAndes: https://uniandes.edu.co/

[12] Universidad Industrial de Santander. (2021, mayo). Retrieved from UIS: https://www.uis.edu.co/webUIS/es/index.jsp